AIのアプリケーションを作るときにデータがなくては学習ができない、データが整っていなければシステムが組めないといったようなデータベース思考の考え方があるが、ここでは、データ群が整ってない企業のケースにおける AIエージェントの導入を思考する。

「運用しながらトランザクションデータを蓄積し、それをマスターデータベース化していく」というアプローチは、LLMベースのAIアプリケーション普及において極めて重要であり、従来のデータベース(DB)思考からの大きな転換点となる。

1. 従来のDB思考とAI開発の障壁

従来のアプリケーション開発やAI開発は、主に以下のDB思考に依存していた。

- 「データ先行」のパラダイム:

- DB思考: アプリケーション構築前に、マスターデータやトランザクションルールを厳密に定義し、データを完全に整備しておく必要がある。

- AI学習: アプリケーション運用前に、十分な量と質の学習データ(教師データなど)を集めて学習を完了させておく必要がある。

このアプローチは、データ収集とアノテーション(ラベル付け)に膨大な時間とコストを要し、特に新しいタスクやニッチな分野でのAIアプリケーション開発を妨げる大きな障壁となっていた。

2. LLMと運用を通じたデータ蓄積の重要性

LLM(大規模言語モデル)の登場は、この障壁を取り払い、「運用先行」のアプローチを可能にする。

a. ベースナレッジ(LLM)の活用

LLMが持つ膨大な事前学習知識(ベースナレッジ)こそが、「データがない状態」でのアプリケーション初期起動を可能にする「仮のマスターデータベース」としての役割を果たす。

- 初期機能の提供: 厳密な教師データがなくても、LLMの推論能力により、ユーザーからの質問応答やタスク実行といった基本的な機能を提供できる。

- プロトタイピングの加速: 最小限の設定で実動するプロトタイプを素早く市場に出すことが可能になる。

b. トランザクションデータの価値転換

アプリケーションを運用し、ユーザーとエージェント(LLM)との対話やエージェントが行ったタスクの記録(トランザクションデータ)を蓄積していくこと自体が、最も価値のある「生きたデータ」となる。

- ファインチューニング: 蓄積された実際の運用データを使い、LLMのファインチューニング(微調整)を行うことで、そのアプリケーション特有のユースケースやビジネスロジックに特化した、より賢いマスターモデルを育てることができる。

- RAG(Retrieval-Augmented Generation): ユーザーの質問と、それに対するLLMの応答の履歴は、RAGシステムで使用するナレッジベースを強化・最新化する貴重なデータとなる。

3. 今後のアプリケーション普及に必要な要素

この「運用先行・成長型」のAIアプリケーションを普及させるためには、以下の要素が不可欠。

| 要素 | 従来のDB思考との違い |

| フィードバックループ | データの質は運用後にユーザーからの評価や修正(Human-in-the-Loop)を通じて高まる。 |

| アジリティ(俊敏性) | 完璧なデータを待たず、実運用を通じてデータを生成し、継続的にモデルを改善する。 |

| データの構造化 | エージェントの実行ログや対話ログを、後で学習や評価に使えるように自動で構造化する仕組み。 |

| セキュリティ | 運用で収集される機密性の高いトランザクションデータを、安全かつプライバシーに配慮して扱う仕組み。 |

結論として、AIアプリケーションの普及は、「完璧なデータがあって初めて機能する」という考え方から、「動かしながらデータを生成・学習・成長する」というパラダイムへ移行しており、LLMはその新しい時代のベースラインとして極めて重要な役割を果たしていると言える。

この考え方において、一定規模のトランザクションができたら、それをRAGに組み込んでいくと言うautomatic自律型のRAG作成機能を別に設ける。

AI:はい、ご提案は非常に理にかなっており、LLMアプリケーションの「運用先行・成長型」パラダイムにおいて不可欠な機能になると考えられます。

トランザクションデータ(エージェントの実行履歴やユーザーとの対話ログ)を自動的にRAG(Retrieval-Augmented Generation)のナレッジベースに組み込む機能は、「自律型RAG作成機能」または「動的(ダイナミック)ナレッジ更新機能」として、アプリケーションの価値を飛躍的に高める。

導入のメリットと効果

この自律型RAG作成機能は、以下の重要なサイクルを自動化し、アプリケーションの「鮮度」と「精度」を維持する。

1. ナレッジの鮮度と関連性の維持

システムの運用に伴って発生する新しい情報、特に特定の顧客や業務特有のニッチな情報(ロングテールデータ)が、自動的にナレッジベースに取り込まれる。

- 従来のRAGでは、ナレッジの更新は手動プロセスでしたが、この自動化機能により、最新のトランザクション、解決策、またはビジネスルールが即座にRAGに反映され、LLMの回答の鮮度(Recency)が保たれる。

2. LLMの「知識の空白」の補完

ベースとなるLLM(大規模言語モデル)は、一般常識や学習時までの知識は豊富ですが、特定の運用環境における最新の事実や独自のルールを知る事はない。

- 自動RAG組み込み機能は、この「知識の空白」を運用データで埋めることで、LLMが「知らない」ために行うハルシネーション(幻覚)のリスクを大幅に低減する。

3. データの品質管理と最適化

単にデータをRAGに入れるだけでなく、組み込む過程で品質管理と最適化を行うことで、RAGのパフォーマンスを最大化できる。

| プロセス | 内容 | 目的 |

| トリガリング | トランザクション件数や特定のイベント(例:重要な問題の解決)をトリガーとする。 | 不必要な更新を避け、効率的に処理を開始する。 |

| フィルタリングと選別 | トランザクションデータから、個人情報(PII)やノイズとなる無関係な情報を除外する。 | データの品質とプライバシーを確保する。 |

| チャンキングと埋め込み(Embedding) | データを検索に適したサイズ(チャンク)に分割し、ベクトルデータベースに格納する。 | 検索の精度(Recall)と速度を向上させる。 |

| メタデータの付与 | データの発生日時、エージェントID、解決ステータスなどのメタデータを付与する。 | 検索時に時間軸や信頼性に基づいてフィルタリングできるようにする。 |

実装上の考慮点

この機能を実装する際には、以下の点に留意する必要がある。

- スケーラビリティ: トランザクションデータは膨大になる可能性があるため、データ取り込み、フィルタリング、ベクトル埋め込みのパイプラインは非同期で動作し、スケーラブルである必要がある。

- ノイズへの対策: トランザクションデータには、ユーザーの誤操作やエージェントの失敗例など、誤った情報やノイズも含まれる。これらのノイズがRAGの精度を下げるのを防ぐため、「信頼度スコア」や「人間のレビュー(Human-in-the-Loop)」を組み込む工程が不可欠。

- レプリケーションとバージョン管理: ライブ運用中のRAGナレッジベースを直接更新するのではなく、一度別の環境で構築・テストしてからスワップ(入れ替え)するバージョン管理機構を設けることが望ましい。これにより、更新プロセス中のエラーがサービス全体に影響を与えるのを防げる。

ワークフローとツールについて

このアプローチは、一般的に「ETL (Extract, Transform, Load)」や「データパイプライン」の考え方を、ベクトルデータベースへの組み込みに特化させたものと考えることができる。

以下に、ワークフローの各ステップと、それに対応する主要なツール(技術スタック)を解説する。

💡自律型RAG追加(動的ナレッジ更新)ワークフロー

ステップ 1: データ抽出 (Extract)

目的: 運用中のアプリケーションから、RAGに組み込むべきトランザクションデータやログを抽出・収集する。

| プロセス | 詳細 |

| トリガリング | 特定の条件(例: 1,000件の新しい対話ログが蓄積、または重要な問題が解決された)を検知してパイプラインを起動する。 |

| データソースの選定 | アプリケーションのデータベース(PostgreSQL, MongoDBなど)やログファイル、データウェアハウス(Snowflake, BigQueryなど)からデータを選び出す。 |

🛠️ 主要なツール/技術

- データパイプラインオーケストレーター:

- Apache Airflow / Prefect / Dagster: パイプラインの実行スケジュール管理と、エラー時のリトライ処理を自動化する。

- クラウドのマネージドサービス: AWS Step Functions, Google Cloud Composer (Airflow), Azure Data Factoryなど。

- データコネクタ:

- SQL/NoSQLクライアントライブラリ: データベースからデータを読み込むためのPythonライブラリ(

psycopg2,pymongoなど)。 - イベントストリーミング: 新しいデータ発生時にリアルタイムで処理を起動する Kafka / Google Pub/Sub / AWS Kinesis など。

- SQL/NoSQLクライアントライブラリ: データベースからデータを読み込むためのPythonライブラリ(

ステップ 2: データ変換と整形 (Transform)

目的: 抽出した生データを、RAGのナレッジとして最適な形に加工・整形する。

このステップが最も重要です。

| プロセス | 詳細 |

| フィルタリング | PII(個人情報)の削除、ノイズ(失敗した対話、無関係なログ)の除外、信頼度スコアの低いデータの破棄。 |

| 構造化/要約 | 長い対話ログを、RAG検索に適した「質問-回答-解決策」形式などに構造化(例: LLM自身を使って要約・構造化させる)。 |

| チャンキング | 長文を意味のある小さな塊(チャンク)に分割する。この際、オーバーラップやメタデータ付与を調整する。 |

| メタデータ付与 | データの発生日時、ユーザーID、カテゴリ、信頼度スコアなどの重要な情報を付与する。 |

🛠️ 主要なツール/技術

- データ処理ライブラリ:

- Pandas / Polars: 大量のデータを高速に処理・整形するためのPythonライブラリ。

- チャンキング/構造化フレームワーク:

- LangChain / LlamaIndex: チャンキング処理、埋め込み処理、およびLLMを使った複雑なデータ変換(要約、構造化、評価)を実行する機能を提供する。

- LLM API:

- OpenAI / Gemini API: 構造化や要約タスクにLLMを活用する場合に使用する。

ステップ 3: データ組み込み (Load)

目的: 整形されたデータをベクトル化し、ベクトルデータベースに格納する。

| プロセス | 詳細 |

| 埋め込み生成 | 整形済みの各チャンクを、埋め込みモデル(Embedding Model)を用いて数値ベクトルに変換する。 |

| ベクトルDBへの格納 | 生成されたベクトルと元のテキストデータ、およびメタデータをベクトルデータベースに挿入する。 |

| インデックス更新 | データベースのインデックスを更新し、新しいデータがすぐに検索可能になるようにする。 |

🛠️ 主要なツール/技術

- 埋め込みモデル:

- OpenAI Embeddings / Cohere Embeddings

- Hugging Faceのオープンソースモデル(例: BGE, E5など)

- ベクトルデータベース:

- Pinecone / Weaviate / Milvus: 大規模なベクトル検索とスケーラビリティに優れている。

- PgVector (PostgreSQL拡張) / Chroma / Qdrant: 比較的小規模なアプリケーションや、既存DBとの統合に利用される。

ステップ 4: 監視とテスト (Monitor & Test)

目的: 更新がRAGの精度に悪影響を与えていないかを確認し、問題があれば通知する。

| プロセス | 詳細 |

| 自動テスト | 更新後のRAGシステムに対し、重要な「テストクエリ」を実行し、回答の正確性(Accuracy)や関連性(Relevance)を自動で評価する。 |

| 品質チェック | 新しく組み込まれたデータの品質(例: ハルシネーションの可能性)をLLM自身に評価させる。 |

| デプロイ/スワップ | テストが成功した場合のみ、本番環境のナレッジベースを新しいものに切り替える。 |

🛠️ 主要なツール/技術

- 評価フレームワーク:

- LangSmith / Ragas: LLMアプリケーションの性能を評価するためのフレームワーク。

- 監視ツール:

- Prometheus / Grafana: パイプラインの実行状況やベクトルDBのメトリクスを監視する。

- ログ管理システム: Elasticsearch (ELK) / Datadog などでエラーログを監視する。

ベクトル次元数とパラメーター数はどれぐらいを想定するか

RAGの自動更新は、データ量と処理コストのバランスが重要。コストパフォーマンスを最適化するための規模感と、システム設計の目安となる次元数、パラメーター数について解説する。

1. RAG追加のコストパフォーマンスが良い規模感

「どのぐらいの規模でRAGに追加するか」は、データ量(件数)ではなく、データの質(情報価値)と更新頻度で判断することが重要。

| 判断基準 | 推奨されるアプローチ | コストパフォーマンスが良い規模感の目安 |

| 情報価値 | 重要なビジネスルールや解決策が確定した時点で更新する。 | 新しいナレッジが10件〜50件 確定した時点 |

| ユーザー影響 | ユーザーの質問応答の成功率が低下し始めたら更新する。 | システム全体の成功率が1〜2% 低下したとき |

| 鮮度要件 | 情報が古くなると困る場合(例: 在庫、価格、最新ニュースなど)は、時間ベースで更新する。 | 毎日、または週に1回の定時実行 |

| コストベース | バッチ処理のコストが許容範囲内であること。 | 処理時間(T)が1時間以内に収まるバッチサイズ |

目安:

- 小さすぎ: 1〜2件の更新でパイプラインを起動すると、オーケストレーションやクラウドサービス(Lambda/Cloud Functionなど)の起動コストが割高になる。

- 大きすぎ: 数万件を一度に処理すると、メモリやCPUの負荷が高まり、失敗時の再実行が困難になる。

- 最適解: $\mathbf{1}$回のバッチで数百件〜数千件の質の高いトランザクションログを処理し、1時間に1回や1日に数回など、定期的なスケジュールで実行するのが最も効率的。

2. ベクトルDBの次元数とパラメーター数の目安

RAGシステムの主要なコストと性能は、使用する埋め込みモデルの選択によって決まる。このモデルが、ベクトルDBの次元数と処理コストを決定する。

a. ベクトル次元数(Dimensionality)

次元数は、埋め込みモデルが出力するベクトルの長さであり、RAGの検索精度(意味の近さ)に直接影響する。

| 想定される次元数 | モデルの例 | 特徴とコストパフォーマンス |

| 768次元 | BGE, E5 (オープンソースの高性能モデル) | コスパが非常に良い。多くの標準的なタスクで十分な精度が出ます。商用利用でもまずこの規模で検討すべき。 |

| 1024次元 | Cohere Embed (中規模) | 高精度と汎用性を両立。より複雑な意味理解が必要な場合に検討する。 |

| 1536次元 | OpenAI text-embedding-ada-002/3 | 以前のデファクトスタンダード。汎用性が高く、処理速度も速いですが、費用はトークン数ベースです。 |

- 推奨: コストと精度のバランスから、まずは768次元のオープンソースモデル(例: BGE Largeなど)から始めるのが最もコストパフォーマンスが良い。

b. パラメーター数(ナレッジベースの規模)

ここでいう「パラメーター数」は、RAGのナレッジベースに格納されるチャンクの総数を指す。

| 規模 | チャンク数(パラメーター)の目安 | 影響と対応策 |

| 小規模 | 1万〜10万チャンク | 既存のDBにpgvectorなどを導入して低コストで運用可能。 |

| 中規模 | 10万〜100万チャンク | 専用のベクトルデータベース(Pinecone, Weaviateなど)の採用を検討。検索速度(レイテンシ)が課題になり始める。 |

| 大規模 | 100万チャンク以上 | シャーディングやインデックス最適化などの高度なチューニングが必要。運用コストが大幅に増加する。 |

コストの考え方: ベクトルデータベースのコストは、主に格納するベクトルの総数とクエリ実行回数で決まる。自動RAG追加機能によりチャンク数が増えすぎると、月々のDB利用料が高騰するため、ナレッジの重複排除や古くなったデータの削除(TTL: Time To Live)の仕組みを設けて、総チャンク数を管理することが必須となる。

まとめ

| 項目 | 最適な判断の着眼点 | 目安となる数値 |

| RAG追加バッチ規模 | 情報価値の確定と処理コスト | 1回のバッチで数百〜数千件の高品質データ |

| 更新頻度 | データの鮮度要件 | 毎日1回〜週に1回の定期実行 |

| ベクトル次元数 | 埋め込みモデルの精度とコスト | 768次元または1536次元 |

| ナレッジベース規模 | 検索速度とDB利用料 | 10万〜100万チャンクを目標に管理 |

以上が、業務を運用しながらナレッジをRAGに溜め込んでいく流れが見えたと思います。

ここからが、私が生み出した、新規性と独自性のアーキテクチャの説明になります。

私は、この一連の考え方を DKC-RAG (Dynamic Knowledge Curation RAG) としました。

- 意味: 動的知識キュレーションRAG。ナレッジベースが静的ではなく、継続的に管理(キュレーション)され、更新され続ける点に焦点を当てている。

- 用途: データ品質管理やフィルタリングなどの「キュレーション」プロセスも重要であることを含意する場合に適している。

ここで「取引のコンテキスト」とは、を考える

「紙資料の構造化データだけでは表現されない、取引の“文脈”をどう埋めるか」です。

商取引には、単なる請求書や納品書に現れない「暗黙の背景知」が存在します。

これを大まかに5つに分類できます。

| コンテキスト種別 | 内容 | 例 |

|---|---|---|

| ① 取引履歴構造 | 誰が誰に何をどれくらいの周期で提供しているか | 年1回の定期発注 or 突発依頼 |

| ② 時間軸関係 | 季節性、年度末特需など | 3月の発注は翌年度準備 |

| ③ 関係性構造 | 顧客担当・仕入先担当・役職関係 | 「A商事はBさん決裁で動く」 |

| ④ 言語・表現のクセ | 特定顧客が使う専門用語、略語 | 「赤ラベル=特注品」 |

| ⑤ 意図・期待値 | 文面外の意図 | 「急ぎ」と書いていないが毎回即納を期待している |

DKC-RAGを育てる戦略

この「暗黙の背景知」に注目しながら、RAG構築をするのだが、一気に構築するのではなく、運用の中で文脈を獲得していく設計が現実的です。

ステージ1:紙資料 → 構造化データ化

- OCR結果を構文単位で整理(取引先・製品・数量・日付・備考など)

- LLMで「項目ラベル付け+補完推定」を同時に行う

→ 例:「備考欄に“例年通り”とある → 過去取引を参照」など

ステージ2:取引パターン抽出

- 構造化データを時系列で並べ、「周期性」「頻度」「変化率」などの特徴量を抽出

→ これをメタデータ(context embedding)として保存する

ステージ3:人間の判断を“文脈タグ”として再利用

- 営業担当がAI提案に対して「正しい・違う」を選ぶ

→ フィードバックを「コンテキストタグ」として記録

→ “この顧客の『特急』は2日以内”など、動的に学習させる

ステージ4:取引ストーリーデータベース化

- 個々の取引データに「前後関係」「理由づけ(why)」を付与

→ 「2023年6月に納期短縮→台風で遅延→翌月発注量増加」など

→ ストーリー系列をベクトルとして扱うことで、RAGに“時系列文脈”が生まれる

コンテキスト獲得のためのデータ構造(概念モデル)

以下のような構造を設計すると有効です:

Transaction {

顧客ID: string,

製品ID: string,

日付: date,

数量: number,

状況: string, // 例: "特急", "再発注", "キャンセル"

備考: text,

関連取引ID: [list],

文脈タグ: [list of {type, value, confidence}]

}

「文脈タグ」はAI運用中に自動的に増えていくフィールドです。

最初は空でも、「AI+人間の対話」から自然に増殖していきます。

実装アプローチ

技術的には次のようなモジュール構成が現実的です:

OCR Parser → Structurer → Context Extractor → RAG Indexer

↑

Human Feedback

- Structurer: OCR結果を正規化(例:「㈱」→「株式会社」)

- Context Extractor: 日付パターン、語彙パターンから取引意図を推定

- RAG Indexer: 構造データ+タグ情報をベクトル化し蓄積

- Human Feedback: 営業担当の判断でタグの正確度を補正

「運用で育てる」仕掛け

RAGを“現場で鍛える”ために次の工夫をします:

- AIが出す提案に対し、人間が選択肢で答えるUIを設計する

(自由入力よりも“選択式の訂正”が学習しやすい) - 日報・対応メモを半構造化して、取引ストーリーを自動紐づけ

- 「タグ出現頻度」をAIが自己評価して、曖昧タグを再整理する

成熟後の姿

時間が経つと、AIは次のようなことが可能になります:

- 「A社のこの季節の発注は来月予定される」

- 「昨年同様の特注依頼が来そう」

- 「この文面(FAX/OCR)パターンはクレーム対応案件」

つまり、RAGが単なる検索エンジンから「関係性予測エージェント」へ進化します。

TACRA (Tacit Contextual Relational Architecture) 暗黙文脈関係構造

私の狙いの本質は

普通のRAGは「文書やFAQを検索する仕組み」ですが、

狙っているのは、“現場の呼吸”を学習するAIエージェント。(このひらめきが新しい方向性に導く)

実現のための設計アプローチ

🔹A. 背景情報を「出来事」として抽出する

ここは、公開していません。

・・・・・・・

価値の訴求ポイント(対社内・経営層向け)

📌「報告を減らして情報精度を上げるAI」が実現できます。

- 社員が報告書を作る時間を削減

- 顧客関係の“温度感”を見える化

- 引継ぎ時に暗黙知を失わない

- トラブル兆候をAIが先読み

- 現場入力ゼロでRAGが育つ

正式名称

TRCRA:Tacit Relational Contextual Reasoning Architecture

コンセプト要約

TRCRAは、報告書や明示的データ入力を必要とせず、

人と組織の相互作用から「暗黙的な関係文脈(Tacit Relational Context)」を抽出・記憶する

自己進化型ナレッジアーキテクチャである。RAG(Retrieval-Augmented Generation)の拡張概念として、

TRCRAは取引・交渉・修正・調整などの“出来事の温度”を自動的にモデル化し、

次世代の顧客関係知性(Relational Intelligence)を構築する。この技術は、将来の自動取引システムの中核技術になると考えています。

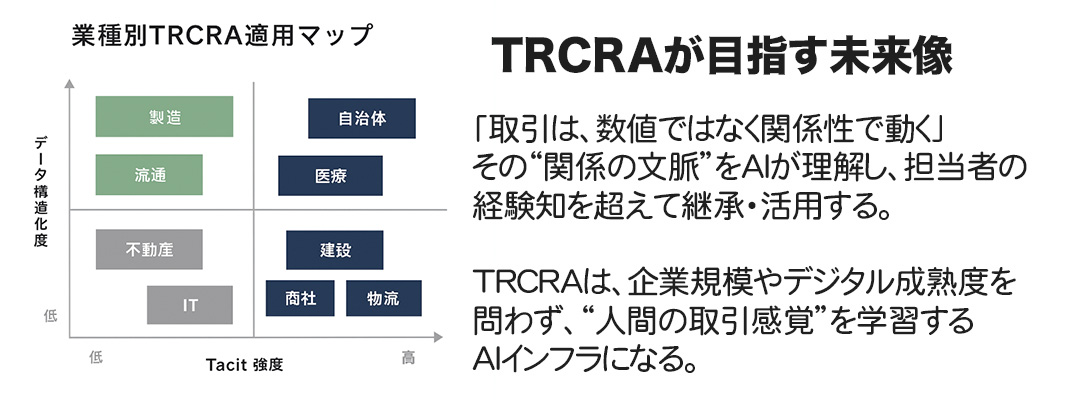

TRCRA(Tacit Relational Contextual Reasoning Architecture)は、“形式知が少なく、関係性や経験則に依存している業務”ほど真価を発揮します。

つまり、「明文化されていないが、現場では共有されている知恵や癖」が多い領域です。

以下に、業種・分野別の適用イメージを整理してみます👇

🧩 TRCRAが特に効く業種・分野一覧

| 分野 | 適用シーン | 期待される効果 |

|---|---|---|

| 製造業(B2B取引) | 部品調達、OEM取引、品質クレーム対応 | 取引先ごとの交渉傾向・納期遵守度を学習し、見積・納期・仕様調整を自動提案 |

| 建設・設備業 | 現場毎の仕様調整、下請け・協力会社との打合せ履歴 | 現場や顧客の“こだわり”を記憶し、担当交代でも同等品質の対応 |

| 商社・卸売業 | 仕入・販売履歴、季節変動、取引慣習 | 相手先の反応・価格交渉傾向をモデル化して営業戦略を最適化 |

| 自治体・公共団体 | 入札、業者選定、議会対応 | 過去の議事録・要望履歴をContext化し、政策対応や文書作成を自動補助 |

| 医療・福祉 | 個別患者・施設対応、行政手続き | 患者や家族、施設担当者との関係履歴を記憶し、ケア調整を支援 |

| 不動産・住宅 | 顧客要望、施工履歴、地域事情 | 顧客タイプ別にコミュニケーション履歴を学習し、契約率・満足度を向上 |

| 物流・運輸 | 配送先や取引先の特性(時間帯、立地制約) | 過去の配達記録から暗黙ルールを学び、ルート最適化や事故防止 |

| 金融・保険 | 融資・契約交渉履歴、顧客行動パターン | 過去のやり取りから「信用行動モデル」を生成し、審査・提案の精度向上 |

| 教育・人材育成 | 生徒や社員ごとの学習・成長履歴 | 一人ひとりの“つまずきパターン”を理解し、個別化教育を支援 |

| 農業・食品流通 | 取引先の気候・地域習慣、農産品品質の差 | シーズンや取引先特性をContextとして保持し、販路提案を自動化 |

TRCRAが企業のサイズを超えて機能する理由

| 規模 | 強み | TRCRAが補う部分 |

|---|---|---|

| 中小企業 | 現場力・経験知が多い | 暗黙知を形式化し、属人化を解消 |

| 中堅企業 | 個別顧客対応のノウハウが蓄積 | 顧客Contextを再利用し、業務を自動化 |

| 大企業 | データ量は多いがContextが失われがち | 取引ごとの“意味”を紐づけ、AI判断の精度を向上 |

using WordPress and

using WordPress and

Comments are closed